Podcast

Questions and Answers

Quel est l'objectif principal de la régression linéaire ?

Quel est l'objectif principal de la régression linéaire ?

- Ajuster un modèle au mieux à un jeu de données (correct)

- Maximiser l'erreur entre les points de données

- Déterminer la relation entre plusieurs variables

- Minimiser la fonction coût

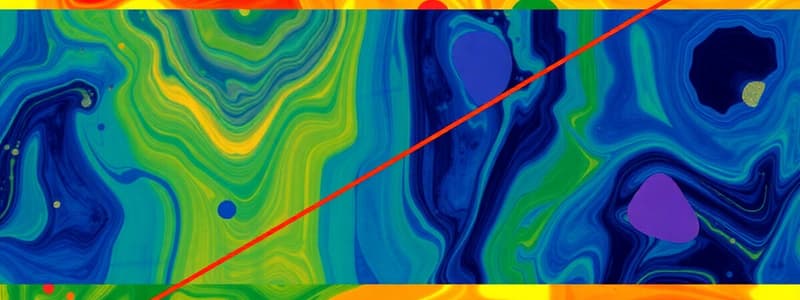

Quelle est la forme que prend la fonction coût lorsque les paramètres w et b varient ?

Quelle est la forme que prend la fonction coût lorsque les paramètres w et b varient ?

- Une sinusoïde

- Un carré

- Une droite

- Une parabole (correct)

Qu'est-ce que la descente de gradient ?

Qu'est-ce que la descente de gradient ?

- Une méthode d'optimisation pour minimiser la fonction de coût (correct)

- Une technique pour maximiser les paramètres

- Un processus pour évaluer les erreurs du modèle

- Un algorithme pour prévoir les données futures

La fonction coût est utilisée pour évaluer quoi dans un modèle de régression linéaire ?

La fonction coût est utilisée pour évaluer quoi dans un modèle de régression linéaire ?

Quel est le rôle des paramètres w et b dans un modèle de régression linéaire ?

Quel est le rôle des paramètres w et b dans un modèle de régression linéaire ?

Flashcards

Qu'est-ce que la régression linéaire ?

Qu'est-ce que la régression linéaire ?

La régression linéaire est une méthode statistique utilisée pour comprendre la relation entre une variable dépendante et une ou plusieurs variables indépendantes. Elle vise à trouver une ligne droite qui représente au mieux la tendance des données.

Qu'est-ce que la fonction coût ?

Qu'est-ce que la fonction coût ?

La fonction coût est une mesure qui évalue la performance d'un modèle de régression linéaire en quantifiant l'écart entre les prédictions du modèle et les données réelles.

Qu'est-ce que la descente de gradient ?

Qu'est-ce que la descente de gradient ?

La descente de gradient est une méthode d'optimisation utilisée pour trouver les meilleurs paramètres d'un modèle en minimisant la fonction coût. Elle fonctionne en ajustant progressivement les paramètres du modèle dans la direction qui réduit le plus l'erreur.

Quelle est l'analogie de la montagne ?

Quelle est l'analogie de la montagne ?

Signup and view all the flashcards

Comment fonctionne le calcul du gradient ?

Comment fonctionne le calcul du gradient ?

Signup and view all the flashcards

Study Notes

Introduction au Gradient Descent

- Le Gradient Descent est une méthode d'optimisation utilisée pour minimiser la fonction de coût (l'erreur).

- L'objectif est de trouver les meilleurs paramètres pour un modèle.

Rappel sur la Régression Linéaire

- La régression linéaire est une méthode utilisée pour modéliser la relation entre une variable dépendante et une ou plusieurs variables indépendantes.

- Un exemple d'équation de régression linéaire simple est y = ax + b.

Fonction Coût

- La fonction coût mesure l'erreur entre les points de données et le modèle de régression.

- Elle quantifie la qualité du modèle.

- La fonction coût est une mesure d'erreur qui évalue la qualité d'un modèle de régression linéaire.

- Elle mesure l'erreur entre chaque point de données et le modèle, puis calcule la moyenne de toutes ces erreurs.

- La fonction coût prend la forme d'une parabole lors de la variation des paramètres.

Analogie de la Montagne

- L'analogie de la montagne illustre le Gradient Descent.

- Le sommet de la montagne représente le maximum de la fonction de coût (la valeur la plus élevée).

- La descente de la montagne représente l'optimisation des paramètres.

Algorithme de la Descente de Gradient

- L'algorithme consiste à trouver le minimum de la fonction coût en suivant la pente de cette fonction (le gradient).

- On ajuste les paramètres jusqu'à trouver le minimum de la fonction de coût.

Explication Mathématique

- L'équation mathématique du Gradient Descent pour la mise à jour des paramètres est ai+1 = ai - α x ∂J(ai)/∂a

- α représente le taux d'apprentissage.

Calcul du Gradient

- Les calculs du gradient permettent de trouver la pente de la fonction coût par rapport à chaque paramètre (a et b).

- ∂J(a,b)/∂a = 1/m * Σ(x(i)(ax(i) +b – y(i)))

- ∂J(a,b)/∂b = 1/m * Σ(ax(i) +b – y(i))

- m représente le nombre d'exemples.

Conclusion

- Résumé de l'approche du Gradient Descent ainsi que de ses étapes clés pour la mise à jour des paramètres d'un modèle de régression linéaire.

- Le Dataset est exprimé comme un ensemble de points (x,y), avec un nombre d'exemples m.

Studying That Suits You

Use AI to generate personalized quizzes and flashcards to suit your learning preferences.